简介

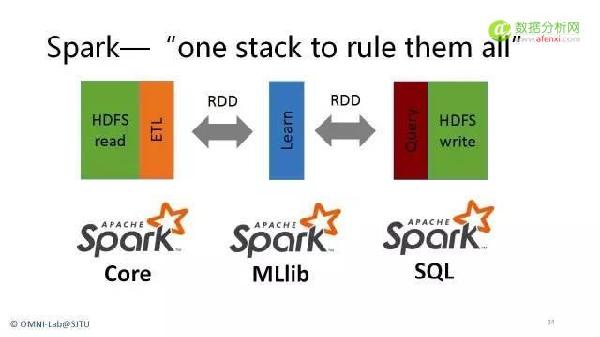

当前,我国已经进入大数据时代,在这样的时代背景下,以Hadoop和Spark为基础的大数据应用也逐渐深入,正在从互联网企业,逐渐拓展到电信,金融,政府,医疗这些传统行业。目前Hadoop和Spark应用场景已广泛应用于日志存储、查询和非结构化数据处理等大数据应用领域,随着Hadoop和Spark技术的不断成熟以及生态系统相关产品的完善,包括Hadoop和Spark对SQL不断加强的支持,以及主流商业软件厂商对Hadoop和Spark支持的不断增强,必定会带动Hadoop 和Spark渗透到越来越多的应用场景中。2016年是中国大数据的应用落地年,越来越多的行业用户开始重视并启动大数据相关的项目。而在大数据领域的众多技术中,最受关注的是衍生于开源平台的Hadoop 和Spark生态系统。Hadoop 从2006 年诞生至今已经超10年时间。2016年,整个生态系统变得比以往更加丰富,无论是在开源领域,商业软件厂商或是硬件厂商,都开始推出基于Hadoop 的相关产品。Hadoop之所以受到如此的关注,主要原因在于它支持用户在低价的通用硬件平台上实现对大数据集的处理和分析,在某种程度上替代了传统数据处理所需的昂贵的硬件设备和商业软件。本课程将全面剖析大数据自动化运维的实战经验和技巧,帮助大数据平台管理和运维工程师轻松运维千节点规模的大数据集群。本课程采用循序渐进的课程讲授方法,首先讲解大数据基本特点以及大数据运维系统构成,接着依次剖析大数据七层架构中每层的运维经验与技巧,最后总结运维千节点集群的常见问题及解决方案。

目标

本课程将为大家全面而又深入的介绍Hadoop和Spark平台的运维实践经验,包括自动化运维、管理、监控以及报警平台的构建经验。

通过本课程实践,帮助学员对大数据运维系统有一个清晰明了的认识;掌握常用的大数据运维工具和系统;了解每个大数据系统的特点以及运维实践。

课程时长

5天(30H)

受众人群

各类 IT/软件企业和研发机构的大数据工程师以及运维工程师。对于怀有大数据平台管理和运维疑问和问题,需要梳理解答的团队和个人,效果最佳。

学员基础

学员学习本课程应具备下列基础知识:1)了解Java语言;2)了解Linux系统;3)数据挖掘基础

分享提纲

| 时间 | 主题 | 授课内容 |

第一天 大数据运维系统基础 | 大数据架构概述 | 1.大数据技术特点 剖析开源、社区模式、更新快等特点 2.大数据六层架构 介绍大数据系统基本架构 3.Hadoop生态系统概述以及版本演化 4.概要介绍Hadoop生态系统及其版本演化历史 |

| 大数据自动化运维挑战 | 1.大规模集群 2.复杂的软件栈 3.问题的复杂性(操作系统、网络、软件、应用程序及用户) | |

| 大数据运维常用技术栈 | 1.Linux机器资源监控与报警 ganglia与nagios 2.常用linux命令 top、free、sar、iostat、nmon、jstack、ssh、rsync,设置hostname等 3.Java基础 JVM、内存管理、GC调优 4.用户管理 LDAP系统 5.自动化安装部署 6.ambari、cloudera manager等 7.动手实践 8.常用linux命令使用方式 9.Java GC调优 | |

| Linux系统基本配置 | 1.大数据系统对linux要求 2.大数据系统常见linux配置 3.动手实践 4.配置自己的Linux系统 | |

| 规划Hadoop集群 | 1.规划的常规考虑 2.选择正确的硬件 3.网络的考虑 4.配置节点 5.规划集群的管理 | |

第二天 数据收集与存储系统运维 | 分布式文件系统HDFS运维 | 1.HDFS原理、特性与基本架构 2.介绍HDFS原理与架构 3.HDFS数据块、读写文件流程 4.HDFS访问方式 5.动手实践 6.搭建HDFS集群 7.HDFS shell使用 8.HDFS WEB UI使用 9.HDFS运维 10.用户管理 11.存储空间管理(目录组织方式、份额设置等) 12.NameNode高可用 13.NameNode元信息备份 14.HDFS机架感知 15.动态增加新的结点 16.尝试恢复丢失的数据块 17.集群间拷贝数据 18.在集群内实现负载均衡 19.动态更换磁盘 20.关键参数设置(垃圾桶、GC,端口号等) 21.动手实践 22.配置NameNode HA,并进行主备切换 23.动态增加HDFS新节点 24.修复丢失的数据块 25.借助日志文件排错 |

| 将数据导入HDFS | 1.flume与sqoop基本架构与原理 介绍如何使用flume和sqoop两个系统将外部流式数据(比如网站日志,用户行为数据等)、关系型数据库(比如MySQL、Oracle等中的数据导入Hadoop中进行分析和挖掘 2.Flume与sqoop运维 3.动手实践 4.使用Flume将日志收集到HDFS中 5.使用Sqoop将MySQL中的表导入到HDFS中 | |

第三天 资源管理系统运维 | 资源管理系统YARN基础 | 1.YARN产生背景及原理 2.YARN基本架构 3.YARN资源调度器 4.以YARN为核心的生态 5.动手实践 6.搭建YARN集群 |

| 资源管理系统YARN运维 | 1.参数配置与调优 2.用户管理 3.资源池划分 4.资源监控 5.动手实践 6.修改YARN的资源量和常用配置参数 7.配置YARN的Fair Schduler | |

| 分布式协调服务Zookeeper | 1.Zookeeper产生背景 2.Zookeeper基本架构 3.Zookeeper设计原理 4.动手实践 5.Zookeeper安装部署 6.Zookeeper参数配置与调优 | |

第四天 分布式计算框架运维 | 分布式计算框架MapReduce | 1.MapReduce基本原理 2.MapReduce应用程序特点 3.如何提交和杀死MapReduce程序 |

| 分布式查询引擎Hive | 1.Hive基本结构与原理 2.Hive数据库和表的管理 3.动手实践 4.Hive安装部署 5.Hive参数设置 6.创建和删除Hive数据库和表 | |

第五天 Cloudera Manager管理Hadoop集群 (视频教学) | CDH发行版基础 | 1.CDH发行版简介 2.Cloudera Manager设计初衷 3.Cloudera Manager基本功能 4.Cloudera Manager对环境要求(OS、网络等) 5.动手实践 6.如何在Cloudera Manager增加新结点 7.如何利用Cloudera Manager部署Zookeeper集群 8.如何利用Cloudera Manager部署HDFS集群 9.如何利用Cloudera Manager部署YARN集群 10.如何利用Cloudera Manager部署Hive 11.常见问题排查与诊断 |

| HDP发行版基础 | 1.HDP发行版简介 2.Ambari设计初衷 3.Ambari基本功能 4.Ambari对环境要求(OS、网络等) 5.动手实践 6.如何在Ambari增加新结点 7.如何利用Ambari部署Zookeeper集群 8.如何利用Ambari部署HDFS集群 9.如何利用Ambari部署YARN集群 10.如何利用Ambari部署Hive 11.常见问题排查与诊断 |

Semon Dong

百林哲咨询(北京)有限公司专家团队成员

Semon Dong

百林哲咨询(北京)有限公司专家团队成员

Semon Dong

百林哲咨询(北京)有限公司专家团队成员

Semon Dong

百林哲咨询(北京)有限公司专家团队成员

Semon Dong

百林哲咨询(北京)有限公司专家团队成员

Semon Dong

百林哲咨询(北京)有限公司专家团队成员

Semon Dong

百林哲咨询(北京)有限公司专家团队成员

京ICP备2022035414号-1

京ICP备2022035414号-1